In addition to the considerations in this post , I add some further reflections on the risks of using ChatGPT and AI tools in general. Professor White, mentioned in the post, advises: 1) to use ChatGPT as a tool for “augmented intelligence” to increase, rather than reduce, our cognitive capabilities; 2) to question whether, because of the way we use AI, it will be easier in the future to replace us with AI itself or with someone who knows how to use it and, in addition, has competencies X, Y, and Z that we do not have or have lost. This is the real question that students who turn to ChatGPT or similar tools to ‘simplify their life’ should also ask themselves. The important issue is not whether by delegating a certain task to AI one might be ‘caught by teachers’, but whether in doing so, one is removing something from their own capabilities, increasing the likelihood, in the future, of becoming superfluous, at least from a work perspective. At the same time, however, educational institutions must ask themselves which old and new contents are significant in the era of AI. The ability to sum a long list of numbers, for example, is not particularly useful if calculators and PCs are available. What skills, then, is it important for students (and teachers) to develop when a myriad of AI tools are available? These will most likely be high-level skills, such as the ability to plan a task and formulate a prompt in a way that achieves a better result, to check the output, and to optimally integrate an AI system within a given context. But a high-level skill, which I believe is equally important, will also be to understand even better when not to use AI. We will talk about this in a future post.

Category: AI

-

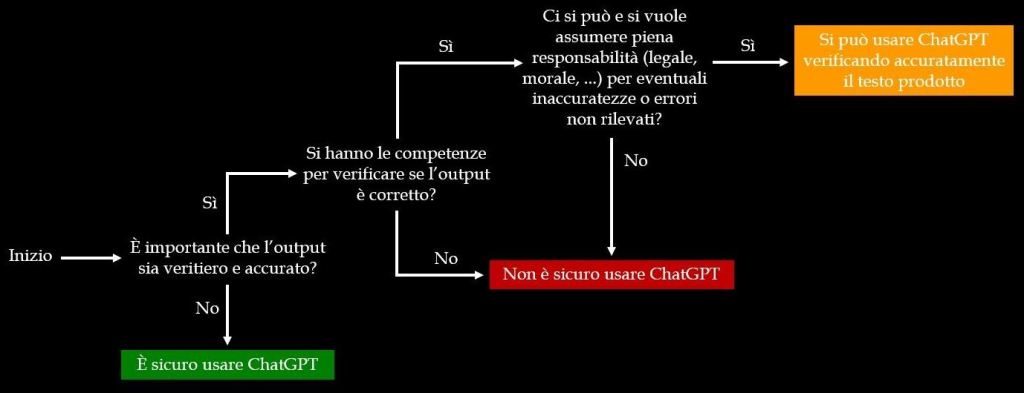

To answer this question, one can first refer to the chart shown below, derived from this UNESCO publication.

Here’s the essence of the chart: ChatGPT responses may contain errors and false or inaccurate information. If this is not a concern, then it is certainly safe to use the model; otherwise, one should ask whether one has the necessary skills to verify if ChatGPT’s output is correct and accurate or not. If you lack these skills, then it is not safe to use ChatGPT. However, if you do possess these skills, as a final step, you need to ask yourself whether you can – and want to – take full responsibility, from every perspective, for any errors or inaccuracies that may go unnoticed. If the answer is no, then, once again, it is not safe to use ChatGPT. If the answer is yes, then you can use the model’s output after carefully verifying it. The same guidelines apply to other systems, such as Google’s Bard, but also more generally. In his Thrustworthy Generative AI course, Professor Jules White (Vanderbilt University) invites us to think about this problem in terms of risk: what consequences could using AI-generated results have? Could there be serious repercussions for people? Economic or reputational harm? Other significant negative effects? Furthermore, is it easy or difficult to verify the obtained answers? If using the output of an AI can have significant consequences, verifying the answers is difficult, and you lack the skills to do so, then it is certainly advisable not to use AI or to use it in a way that reduces risks. How? Professor White provides these two examples: instead of asking ChatGPT if it is safe to take drug X (high risk), you can ask what questions it would be appropriate to ask a doctor, i.e. an expert, to evaluate the safety of taking X given your health conditions (lower risk, possibly affecting your reputation). Furthermore, instead of asking ChatGPT to extract/summarize critical information from a certain document (high risk), you can ask it to identify where in the document that information can be found (lower risk).

Using AI correctly requires not fewer skills but more skills, despite the countless charlatans who present AI as a sort of genie in a bottle that provides the solution to this or that problem without any effort on your part. A story that has been heard a million times, and just as many times proven false, if not dangerous. -

Per rispondere a questa domanda si può, innanzi tutto, fare riferimento al grafico mostrato qui sotto, derivato da questa pubblicazione UNESCO.

Ecco il senso del grafico: le risposte di ChatGPT possono contenere errori e informazioni false o non accurate. Se questo non costituisce un problema allora è senz’altro sicuro usare il modello, in caso contrario occorre chiedersi se si hanno le competenze necessarie per verificare se l’output di ChatGPT sia corretto e accurato oppure no. Se non si possiedono queste competenze allora non è sicuro usare ChatGPT, altrimenti, come ultimo passo, è necessario domandarsi se ci si può – e si vuole – assumere la piena responsabilità, sotto ogni punto di vista, per eventuali errori o inaccuratezze non rilevate. Se la risposta è no allora, di nuovo, non è sicuro utilizzare ChatGPT, e se invece è sì l’output del modello si può utilizzare dopo averlo attentamente verificato. Le stesse indicazioni valgono per altri sistemi, come ad esempio Bard di Google, ma anche più in generale. Nel suo corso Thrustworthy Generative AI il prof. Jules White (Vanderbilt University) invita a pensare a questo problema in termini di rischio: usare i risultati prodotti da una IA quali conseguenze potrebbe avere? Ci potrebbero essere serie ripercussioni sulle persone? Danni economici o alla propria reputazione? Altri importanti effetti negativi? E ancora: verificare le risposte ottenute è facile o difficile? Se utilizzare l’output di una IA può avere conseguenze importanti, verificare le risposte ottenute è difficile e non si hanno le competenze per farlo allora è senz’altro raccomandabile non usare l’IA oppure utilizzarla in modo tale da ridurre i rischi. Come? White fa questi esempi: non va chiesto a ChatGPT se sia sicuro assumere il farmaco X (rischio elevato), ma eventualmente quali domande sia opportuno fare a un medico, cioè a un esperto, per valutare se sia sicuro assumere X date le proprie condizioni di salute (rischio minore, al più alla propria reputazione). E ancora: anziché chiedere a ChatGPT di estrarre/riassumere informazioni critiche da un certo documento (rischio alto) si può chiedergli di individuare dove, in quel documento, si trovino quelle informazioni (rischio più basso). Usare correttamente l’IA non richiede meno competenze, ma più competenze, nonostante i mille imbonitori che spacciano l’IA stessa per una specie di genio della lampada che fornisce la soluzione di questo o quel problema senza che si debba fare nulla. Una storia già sentita un milione di volte, e altrettante volte rivelatasi falsa, se non pericolosa.

-

Un prompt di ChatGPT è un’istruzione o una domanda fornita dall’utente che guida l’IA nella generazione di una risposta. La qualità di un prompt può influenzare significativamente la pertinenza e l’utilità del risultato ottenuto. I buoni prompt sono chiari, specifici e forniscono abbastanza informazioni contestuali per indirizzare ChatGPT verso l’esito desiderato. Spesso contengono dettagli espliciti sul compito richiesto, incluse eventuali informazioni di base che il modello potrebbe dover conoscere per fornire una risposta accurata. Al contrario, un cattivo prompt può essere vago, ambiguo o mancare dei dettagli necessari per ottenere una risposta precisa. Questo può portare a fraintendimenti o risultati che non soddisfano le esigenze dell’utente. Ad esempio, un buon prompt potrebbe essere: “Spiega il processo della fotosintesi nelle piante, dettagliando le reazioni chimiche e il ruolo della clorofilla”. Questo prompt è specifico e comunica a ChatGPT quali informazioni siano richieste esattamente. Un prompt meno buono, invece, potrebbe essere: “Parlami delle piante”. Questa richiesta è vaga e non indica quali aspetti delle piante interessano all’utente, cosa che può condurre ad una risposta generica.

La natura dei prompt per ChatGPT obbliga gli utenti ad avere una visione molto chiara di ciò che vogliono ottenere e di come esprimerlo. Tale chiarezza è essenziale perché, a differenza delle conversazioni umane, non può esserci un’intesa linguistica tacita tra un umano e il modello. La comunicazione umana si basa spesso su un contesto implicito condiviso, segnali non verbali e una comprensione comune sviluppata nel tempo, che attualmente l’IA non può replicare completamente. Pertanto, è compito dell’utente fornire istruzioni esplicite che lasciano poco spazio all’interpretazione, garantendo una risposta più accurata e utile da parte di ChatGPT. Questo ci costringe ad articolare i nostri pensieri in modo più preciso e sistematico, e incoraggia l’esattezza nella comunicazione. Decisamente, non una brutta cosa.

-

A ChatGPT prompt is a user-provided instruction or question that guides the AI in generating a response. The quality of a prompt can significantly influence the relevance and usefulness of the AI’s output. Good prompts are clear, specific, and provide enough context to direct the model towards the desired outcome. They often contain explicit details about the task, including any necessary background information that the AI might need to know to provide an accurate response. Conversely, a bad prompt may be vague, ambiguous, or lack the details necessary to yield a precise answer. Such prompts can lead to misunderstandings or responses that don’t meet the user’s needs. For example, a good prompt might be: “Explain the process of photosynthesis in plants, detailing the chemical reactions and the role of chlorophyll”. This prompt is specific and informs the AI of the exact information required. A bad prompt, however, might be: “Tell me about plants”. This is vague and does not specify what aspects of plants the user is interested in, which can result in a broad and unfocused response.

The nature of prompts in ChatGPT forces users to have a very clear view of what they want to achieve and how to express it. Such clarity is essential because, unlike human conversations, there cannot be tacit linguistic agreements between a human and ChatGPT. Human communication often relies on shared context, non-verbal cues, and common understanding developed over time, which AI currently cannot fully replicate. Therefore, the onus is on the user to provide explicit instructions that leave little room for interpretation, ensuring a more accurate and helpful response from the model. This requirement encourages precision in thought and communication and compels us to articulate our thoughts more systematically. Definitely, not a bad thing.

-

Partiamo dal nome. OpenAI è l’azienda che ha sviluppato ChatGPT. Chat sta per “chat bot”, cioè un software capace di simulare una conversazione umana. Generative significa che questo sistema genera qualcosa, nel caso specifico caso testi. Pretrained indica che ChatGPT è pre-addestrato (su testi). Il termine transformer si riferisce al tipo di modello informatico utilizzato e, infine, 3.5 è la versione che stiamo considerando. ChatGPT 3.5 è al momento gratuito. Suo fratello maggiore, il 4.0, è invece a pagamento e ne parleremo più avanti.

ChatGPT fa parte dei cosiddetti modelli linguistici di grandi dimensioni (Large Language Models o LLM). Sono sistemi addestrati su enormi quantità di testi a riconoscere le relazioni tra parole, anche distanti tra loro, e funzionano cercando di prevedere la parola successiva in un testo basandosi su ciò che è stato scritto in precedenza dall’utente o dal modello stesso.

Un LLM sfrutta le sue vaste informazioni sulle strutture del linguaggio per completare e arricchire il testo sulla base delle richieste dell’utente. Questi modelli sono fondati sulle cosiddette reti neurali, che si possono immaginare come reti di piccole unità di elaborazione (nodi) connesse tra loro. Potete trovare qui o qui una serie di video accessibili su queste reti, sugli LLM e su altri argomenti interessanti (sono in inglese, al momento non ne ho reperiti di così abbordabili in italiano, ma continuerò a cercare).

ChatGPT interagisce con l’utente in linguaggio naturale, ad esempio inglese o italiano (sull’inglese è più competente), può scegliere parole diverse così da variare i contenuti delle risposte, può generare testi coerenti con differente grado di complessità, struttura e tono, e ricorda fino a un certo punto i contenuti di una conversazione.

L’addestramento di ChatGPT 3.5 è terminato a gennaio 2022, quindi il sistema non contiene alcun riferimento a fatti successivi a quella data (ad esempio alla vittoria dell’Argentina, a dicembre, del campionato di calcio FIFA 2023).

La comprensione del significato dei testi è soltanto simulata e le informazioni fornite (come fatti o citazioni bibliografiche) possono essere inesatte o false. Questo diventa un problema critico solo se il modello è utilizzato in modo improprio (di questo parleremo in altri post). ChatGPT non è un motore di ricerca, ma può essere connesso alla rete, e non è molto adatto per eseguire calcoli numerici complessi o operazioni che li coinvolgono. In ogni momento l’unità di lavoro massima gestibile è di circa un foglio A4 (ma dipende dai casi). Infine, le conversazioni sono memorizzate per un certo periodo e possono essere analizzate da operatori umani; non vanno inserite informazioni coperte da privacy o soggette ad altri vincoli di diffusione.

Per iniziare a utilizzare ChatGPT potete partire da qui e seguire le istruzioni. Il web è pieno di materiali sull’uso di questo modello, ma nei futuri post, oltre a raccontarne un po’ di più, ci concentreremo anche su aspetti forse meno discussi. A presto.

-

Let’s start with the name. OpenAI is the company that developed ChatGPT. Chat stands for “chatbot”, which is software capable of simulating a human conversation. Generative means that this system generates something, in this case, texts. Pretrained indicates that ChatGPT is pre-trained (on texts). The term transformer refers to the type of computer model used, and finally, 3.5 is the version we are considering. ChatGPT 3.5 is currently free. Its big brother, 4.0, is instead paid, and we will talk about it later.

ChatGPT is part of the so-called large language models (LLM). They are systems trained on enormous amounts of texts to recognize the relationships between words, even distant ones, and work by trying to predict the next word in a text based on what has been written previously by the user or the model itself.

An LLM uses its vast information on language structures to complete and enrich the text based on user requests. These models are founded on so-called neural networks, which can be imagined as networks of small processing units (nodes) connected to each other. You can find here or here a series of accessible videos on these networks, on LLMs, and other interesting topics.

ChatGPT interacts with the user in natural language, for example English, can choose different words to vary the contents of the responses, can generate coherent texts with different degrees of complexity, structure, and tone, and remembers to a certain extent the contents of a conversation.

The training of ChatGPT 3.5 ended in January 2022, so the system does not contain any reference to facts subsequent to that date (for example, Argentina’s victory in December at the FIFA 2023 football championship).

The understanding of the meaning of texts is only simulated, and the information provided (such as facts or bibliographic citations) might be inaccurate or false. This becomes a critical problem only if the model is used improperly (we will talk about this in other posts). ChatGPT is not a search engine, but it can be connected to the web, and it is not very suitable for performing complex numerical calculations or operations that involve them. At any time, the maximum workable unit is about an A4 sheet (but it depends on the cases). Finally, conversations are stored for a certain period and can be analyzed by human operators; information covered by privacy or subject to other dissemination constraints should not be entered.

To begin using ChatGPT you can start here and follow the instructions. The web is full of materials on the use of this model, but in future posts, in addition to telling a little more, we will also focus on perhaps less discussed aspects. See you soon.