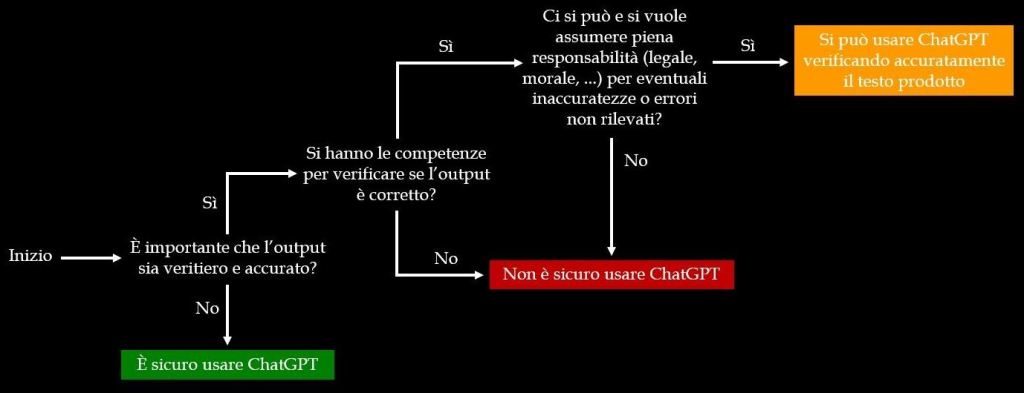

Per rispondere a questa domanda si può, innanzi tutto, fare riferimento al grafico mostrato qui sotto, derivato da questa pubblicazione UNESCO.

Ecco il senso del grafico: le risposte di ChatGPT possono contenere errori e informazioni false o non accurate. Se questo non costituisce un problema allora è senz’altro sicuro usare il modello, in caso contrario occorre chiedersi se si hanno le competenze necessarie per verificare se l’output di ChatGPT sia corretto e accurato oppure no. Se non si possiedono queste competenze allora non è sicuro usare ChatGPT, altrimenti, come ultimo passo, è necessario domandarsi se ci si può – e si vuole – assumere la piena responsabilità, sotto ogni punto di vista, per eventuali errori o inaccuratezze non rilevate. Se la risposta è no allora, di nuovo, non è sicuro utilizzare ChatGPT, e se invece è sì l’output del modello si può utilizzare dopo averlo attentamente verificato. Le stesse indicazioni valgono per altri sistemi, come ad esempio Bard di Google, ma anche più in generale. Nel suo corso Thrustworthy Generative AI il prof. Jules White (Vanderbilt University) invita a pensare a questo problema in termini di rischio: usare i risultati prodotti da una IA quali conseguenze potrebbe avere? Ci potrebbero essere serie ripercussioni sulle persone? Danni economici o alla propria reputazione? Altri importanti effetti negativi? E ancora: verificare le risposte ottenute è facile o difficile? Se utilizzare l’output di una IA può avere conseguenze importanti, verificare le risposte ottenute è difficile e non si hanno le competenze per farlo allora è senz’altro raccomandabile non usare l’IA oppure utilizzarla in modo tale da ridurre i rischi. Come? White fa questi esempi: non va chiesto a ChatGPT se sia sicuro assumere il farmaco X (rischio elevato), ma eventualmente quali domande sia opportuno fare a un medico, cioè a un esperto, per valutare se sia sicuro assumere X date le proprie condizioni di salute (rischio minore, al più alla propria reputazione). E ancora: anziché chiedere a ChatGPT di estrarre/riassumere informazioni critiche da un certo documento (rischio alto) si può chiedergli di individuare dove, in quel documento, si trovino quelle informazioni (rischio più basso). Usare correttamente l’IA non richiede meno competenze, ma più competenze, nonostante i mille imbonitori che spacciano l’IA stessa per una specie di genio della lampada che fornisce la soluzione di questo o quel problema senza che si debba fare nulla. Una storia già sentita un milione di volte, e altrettante volte rivelatasi falsa, se non pericolosa.